目的

本研究では視覚と聴覚の2つの情報を利用し,効率よくロボットの行動を制御するこ

とを目指す.そのためにまず,ロボットに指示を与える人物(指示者)を効率よく探索

することを取り上げる.これは人間とロボットとの間で基本的でかつ重要なインタラ

クション「人が呼んだらロボットが振り向き,その人を認識し,その人のもとにやっ

てくる」という動作である.指示者はロボットに呼び掛け,手招きを行いロボットを

呼ぼうとし,ロボットはそれに反応して指示者を探索する.使用したロボットを図1

に示す.

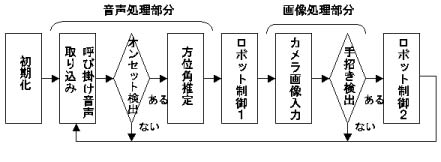

システム概要

図2に処理の概要を示す.音声処理部分ではロボットは呼び掛け音声の方向を推定

し,その方向に回転して指示者をロボット視野内に収める.音源定位にはマイクを4

つ使用し,2組の音の立ち上がり(オンセット)時間差によりロボットの周囲360°の範

囲で方向推定する.

指示者をロボット視野内に収めた後,画像処理部分ではロボットは

手招き動作の検出を行い,視野内の人物からさらに精度よく指示者を

特定,位置の把握をする.手招き動作検出にはフレーム間差分処理と

肌色抽出を使用し,手招き動作部分の方向を特定する.

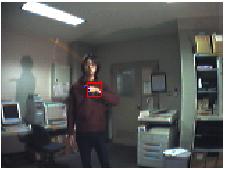

結果・考察

以上のシステムを実装し,実験を行った.その結果,指示者探索において

良好な結果が得られた.手招き検出結果を図3に示す.

視覚だけに頼ったシステムの場合,ロボットが常に

その場で回転し指示者を探索する,指示者がわざわざロボットの視野内

に入っていくといった非効率的な行動が必要となる.

しかし本研究のシステムでは,より人間同士のコミュニケーションに近い

形でかつ効率的に指示者の探索,特定が可能であることが分かった.

|

|

|